Какво представлява файлът Robots.txt в домейн?

Една от най-големите грешки за собствениците на нови уебсайтове е да не се вглеждат в техния файл robots.txt. И така, какво е така и защо толкова важно? Имаме вашите отговори.

Ако притежавате уебсайт и се грижите за негоSEO здраве, трябва да се запознаете много добре с файла robots.txt във вашия домейн. Вярвате или не, това са смущаващо голям брой хора, които бързо стартират домейн, инсталират бърз уебсайт на WordPress и никога не си правят труда да правят нищо с файла си robots.txt.

Това е опасно. Неправилно конфигуриран файл robots.txt може всъщност да унищожи SEO здравето на вашия сайт и да повреди всички шансове, които може да имате за увеличаване на трафика си.

Какво представлява файлът Robots.txt?

Най- Robots.txt файл е подходящо наречен, защото по същество е aфайл, който изброява директиви за уеб роботи (като роботи в търсачката) за това как и какво могат да обхождат на вашия уебсайт. Това е уеб стандарт, следван от уебсайтове от 1994 г. и всички основни уеб сканери се придържат към стандарта.

Файлът се съхранява в текстов формат (с a.txt разширение) в основната папка на вашия уебсайт. Всъщност можете да видите файла robot.txt на всеки уебсайт само като напишете домейна, последван от /robots.txt. Ако опитате това с groovyPost, ще видите пример за добре структуриран файл robot.txt.

Файлът е прост, но ефективен. Този примерен файл не прави разлика между роботи. Командите се издават на всички роботи чрез използване на Потребителски агент: * директива. Това означава, че всички команди, които го следват, се прилагат за всички роботи, които посещават сайта, за да го обхождат.

Посочване на уеб сканери

Можете също така да посочите конкретни правила законкретни уеб сканери. Например, можете да разрешите на Googlebot (уеб браузър на Google) да обхожда всички статии на вашия сайт, но може да искате да забраните на руския уеб браузър Yandex Bot да обхожда статии на вашия сайт, които имат пренебрежителна информация за Русия.

Има стотици уеб сканери, които търсят в интернет за информация за уебсайтове, но 10-те най-често срещани, за които трябва да се притеснявате, са изброени тук.

- Googlebot: Google търсачка

- Bingbot: Търсачката на Bing на Microsoft

- сърбам: Търсачка Yahoo

- DuckDuckBot: Търсачката DuckDuckGo

- Baiduspider: Китайска търсачка Baidu

- YandexBot: Руска търсачка Yandex

- Exabot: Френска търсачка Exalead

- Facebot: Роботният бот на Facebook

- ia_archiver: Търсачка на уебсайтове на Alexa

- MJ12bot: Голяма база данни за индексиране на връзки

Ако вземете примерния сценарий по-горе, ако искатеза да позволите на Googlebot да индексира всичко на вашия сайт, но искате да блокира Yandex да индексира съдържанието ви на руска основа, добавете следните редове към файла си robots.txt.

User-agent: googlebot

Disallow: Disallow: /wp-admin/

Disallow: /wp-login.php

User-agent: yandexbot

Disallow: Disallow: /wp-admin/

Disallow: /wp-login.php

Disallow: /russia/

Както можете да видите, първият раздел само блокираGoogle от обхождане на вашата страница за вход в WordPress и административни страници. Вторият раздел блокира Yandex от същия, но също така и от целия район на вашия сайт, където сте публикували статии със антируско съдържание.

Това е прост пример за това как можете да използвате Забрана команда за контрол на конкретни уеб сканери, които посещават вашия уебсайт.

Други Robots.txt команди

Disallow не е единствената команда, до която имате достъп във вашия файл robots.txt. Можете също да използвате някоя от другите команди, които ще насочат как робот може да обхожда вашия сайт.

- Забрана: Казва на потребителския агент, за да избегне обхождането на конкретни URL адреси или цели секции на вашия сайт.

- Позволява: Позволява ви да прецизирате конкретни страници или подпапки на вашия сайт, въпреки че може да сте забранили родителската папка. Например, можете да забраните: / about /, но след това да разрешите: / about / ryan /.

- Crawl-закъснение: Това казва на робота да изчака xx брой секунди, преди да започне да обхожда съдържанието на сайта.

- Карта на сайта: Осигурете на търсачките (Google, Ask, Bing и Yahoo) местоположението на вашите XML Sitemap-и.

Имайте предвид, че ботовете ще само слушайте командите, които сте предоставили, когато посочвате името на бота.

Честа грешка, която хората правят е забраняването на области като / wp-admin / от всички ботове, но след това посочват раздел за googlebot и само забрана за други области (като / около /).

Тъй като ботовете следват само командите, които сте посочили в техния раздел, трябва да рестартирате всички тези команди, които сте посочили за всички ботове (използвайки * user-agent).

- Забрана: Командата, използвана за да каже на потребителски агент да не обходи конкретен URL. За всеки URL адрес е разрешен само един ред „Disallow:“.

- Разрешаване (приложимо само за Googlebot): Командата да кажа на Googlebot, че има достъп до страница или подпапка, въпреки че нейната родителска страница или подпапка може да бъде забранена.

- Crawl-закъснение: Колко секунди трябва да изчака един робот, преди да зареди и обхожда съдържанието на страницата. Обърнете внимание, че Googlebot не потвърждава тази команда, но честотата на обхождане може да бъде зададена в Google Search Console.

- Карта на сайта: Използва се за извикване на местоположението на XML Sitemap (и), свързани с този URL адрес. Забележете, че тази команда се поддържа само от Google, Ask, Bing и Yahoo.

Имайте предвид, че robots.txt има за цел да помогне на законните ботове (като ботове в търсачките) да обхождат по-ефективно вашия сайт.

Там има много злобни роудърикоито обхождат вашия сайт, за да правят неща като остъргват имейл адреси или да откраднат съдържанието ви. Ако искате да опитате и да използвате файла си robots.txt, за да блокирате тези сканери да не обхождат нещо на вашия сайт, не се притеснявайте. Създателите на тези сканери обикновено игнорират всичко, което сте поставили във файла си robots.txt.

Защо да забранявам нещо?

Намирането на търсачката на Google да обхожда възможно най-качествено съдържание на уебсайта Ви е основна грижа за повечето собственици на уебсайтове.

Google обаче харчи само ограничено обходете бюджет и честота на обхождане на отделни сайтове. Коефициентът на обхождане е колко искания в секунда ще направи Googlebot към вашия сайт по време на събитието за обхождане.

По-важен е бюджетът за обхождане, как емного общи заявки, които Googlebot ще направи, за да обхожда вашия сайт в рамките на една сесия. Google „харчи“ бюджета си за обхождане, като се съсредоточава върху областите на вашия сайт, които са много популярни или променени наскоро.

Не сте слепи за тази информация Ако посетите Google Инструменти за уеб администратори, можете да видите как роботът обработва вашия сайт.

Както можете да видите, роботът поддържа дейността си на вашия сайт доста постоянна всеки ден. Той не обхожда всички сайтове, а само онези, които счита за най-важните.

Защо оставяме на Googlebot да реши какво еважно за вашия сайт, когато можете да използвате файла си robots.txt, за да му кажете кои са най-важните страници? Това ще попречи на Googlebot да губи време на страници с ниска стойност на вашия сайт.

Оптимизиране на бюджета за обхождане

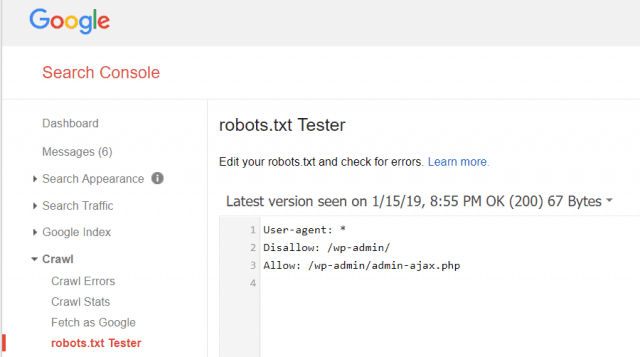

Google Инструменти за уеб администратори също ви позволява да проверите дали Googlebot чете добре вашия файл robots.txt и дали има грешки.

Това ви помага да проверите дали сте структурирали файла си robots.txt правилно.

Какви страници трябва да забраните от Googlebot? Добре е SEO на вашия сайт да забрани следните категории страници.

- Дублиращи се страници (като удобни за печат страници)

- Благодарим ви страници, следващи формулярни поръчки

- Формуляри за заявка за поръчка или информация

- Страници за контакти

- Страници за вход

- Страници за продажби на оловен магнит

Не пренебрегвайте файла си Robots.txt

Най-голямата грешка, която правят новите собственици на уебсайтове едори не гледат файла им robots.txt. Най-лошата ситуация би могла да бъде, че файлът robots.txt всъщност блокира вашия сайт или области на вашия сайт от изобщо да обхождате.

Не забравяйте да прегледате файла си robots.txt и се уверете, че е оптимизиран. По този начин Google и други важни търсачки „виждат“ всички страхотни неща, които предлагате на света с вашия уебсайт.

![Присъединете се към домейна на Windows в Active Directory с Windows 7 или Vista [Как да направите]](/images/vista/join-an-active-directory-windows-domain-with-windows-7-or-vista-how-to.png)

Оставете коментар