Wat is het Robots.txt-bestand in een domein?

Een van de grootste fouten voor nieuwe website-eigenaren is niet in hun robots.txt-bestand kijken. Dus wat is het eigenlijk en waarom zo belangrijk? Wij hebben jouw antwoorden.

Als u een website bezit en om uw site geeftSEO gezondheid, u moet uzelf vertrouwd maken met het robots.txt-bestand op uw domein. Geloof het of niet, dat zijn een verontrustend hoog aantal mensen dat snel een domein start, een snelle WordPress-website installeert en nooit de moeite neemt om iets te doen met hun robots.txt-bestand.

Dit is gevaarlijk. Een slecht geconfigureerd robots.txt-bestand kan de SEO-gezondheid van uw site zelfs vernietigen en schade toebrengen aan uw kansen op groei van uw verkeer.

Wat is het bestand Robots.txt?

De Robots.txt bestand heeft de toepasselijke naam omdat het in wezen een isbestand met richtlijnen voor de webrobots (zoals robots voor zoekmachines) over hoe en wat ze op uw website kunnen crawlen. Dit is een webstandaard gevolgd door websites sinds 1994 en alle grote webcrawlers houden zich aan de norm.

Het bestand wordt opgeslagen in tekstformaat (met een.txt-extensie) in de hoofdmap van uw website. In feite kunt u het robot.txt-bestand van elke website bekijken door het domein te typen, gevolgd door /robots.txt. Als je dit met groovyPost probeert, zie je een voorbeeld van een goed gestructureerd robot.txt-bestand.

Het bestand is eenvoudig maar effectief. Dit voorbeeldbestand maakt geen onderscheid tussen robots. De opdrachten worden aan alle robots gegeven met behulp van de User-agent: * richtlijn. Dit betekent dat alle opdrachten die erop volgen van toepassing zijn op alle robots die de site bezoeken om het te crawlen.

Webcrawlers opgeven

U kunt ook specifieke regels opgeven voorspecifieke webcrawlers. U kunt bijvoorbeeld toestaan dat Googlebot (de webcrawler van Google) alle artikelen op uw site crawlt, maar u wilt de Russische webcrawler Yandex Bot mogelijk niet toestaan artikelen op uw site te crawlen die onaangename informatie over Rusland bevatten.

Er zijn honderden webcrawlers die op internet zoeken naar informatie over websites, maar de 10 meest voorkomende waarover u zich zorgen moet maken, vindt u hier.

- Googlebot: Google zoekmachine

- Bingbot: Microsoft's Bing-zoekmachine

- Slurp: Yahoo-zoekmachine

- DuckDuckBot: DuckDuckGo zoekmachine

- Baiduspider: Chinese Baidu-zoekmachine

- YandexBot: Russische Yandex-zoekmachine

- Exabot: Franse Exalead-zoekmachine

- Facebot: De kruipende bot van Facebook

- ia_archiver: Alexa’s webclassificatiecrawler

- MJ12bot: Grote database voor linkindexering

We nemen het bovenstaande scenario als je wildeom Googlebot in staat te stellen alles op uw site te indexeren, maar Yandex wilt blokkeren voor het indexeren van uw Russische artikelinhoud, voegt u de volgende regels toe aan uw robots.txt-bestand.

User-agent: googlebot

Disallow: Disallow: /wp-admin/

Disallow: /wp-login.php

User-agent: yandexbot

Disallow: Disallow: /wp-admin/

Disallow: /wp-login.php

Disallow: /russia/

Zoals u ziet, blokkeert de eerste sectie alleenGoogle crawlt uw WordPress-inlogpagina en beheerpagina's. Het tweede gedeelte blokkeert Yandex van hetzelfde, maar ook van het hele gebied van uw site waar u artikelen met anti-Rusland-inhoud heeft gepubliceerd.

Dit is een eenvoudig voorbeeld van hoe u de kunt gebruiken Disallow commando om specifieke webcrawlers te besturen die uw website bezoeken.

Andere Robots.txt-opdrachten

Disallow is niet de enige opdracht waartoe u toegang hebt in uw robots.txt-bestand. U kunt ook een van de andere opdrachten gebruiken die bepalen hoe een robot uw site kan doorzoeken.

- Disallow: Laat de user-agent voorkomen dat specifieke URL's of hele secties van uw site worden gecrawld.

- Toestaan: Hiermee kunt u specifieke pagina's of submappen op uw site verfijnen, ook al heeft u een bovenliggende map mogelijk niet toegestaan. U kunt bijvoorbeeld: / about / niet toestaan, maar dan toestaan: / about / ryan /.

- Crawl-delay: Dit vertelt de crawler dat hij xx aantal seconden moet wachten voordat hij begint met het crawlen van de inhoud van de site.

- Sitemap: Geef zoekmachines (Google, Ask, Bing en Yahoo) de locatie van uw XML-sitemaps.

Houd er rekening mee dat bots dat wel zullen doen enkel en alleen luister naar de opdrachten die je hebt opgegeven wanneer je de naam van de bot opgeeft.

Een veel voorkomende fout die mensen maken, is het weigeren van gebieden zoals / wp-admin / van alle bots, maar geef vervolgens een googlebot-sectie op en alleen andere gebieden (zoals / over /).

Aangezien bots alleen de opdrachten volgen die u in hun sectie opgeeft, moet u al die andere opdrachten die u hebt opgegeven voor alle bots opnieuw gebruiken (met de * user-agent).

- Disallow: De opdracht die wordt gebruikt om een user-agent te vertellen dat hij bepaalde URL niet moet crawlen. Voor elke URL is slechts één regel 'Disallow:' toegestaan.

- Toestaan (alleen van toepassing op Googlebot): Het commando om Googlebot te vertellen dat het toegang heeft tot een pagina of submap, hoewel de bovenliggende pagina of submap mogelijk niet is toegestaan.

- Crawl-delay: Hoeveel seconden een crawler moet wachten voordat pagina-inhoud wordt geladen en gecrawld. Houd er rekening mee dat Googlebot deze opdracht niet erkent, maar dat de crawlsnelheid kan worden ingesteld in Google Search Console.

- Sitemap: Wordt gebruikt om de locatie van een XML-sitemap (s) op te roepen die aan deze URL zijn gekoppeld. Let op: deze opdracht wordt alleen ondersteund door Google, Ask, Bing en Yahoo.

Houd er rekening mee dat robots.txt is bedoeld om legitieme bots (zoals bots van zoekmachines) te helpen uw site effectiever te doorzoeken.

Er zijn veel gemene rupsen die er zijndie uw site crawlen om dingen te doen zoals e-mailadressen schrapen of uw inhoud stelen. Als u wilt proberen uw robots.txt-bestand te gebruiken om te voorkomen dat die crawlers iets op uw site crawlen, doe dan geen moeite. De makers van die crawlers negeren meestal alles wat u in uw robots.txt-bestand heeft geplaatst.

Waarom iets niet toestaan?

De zoekmachine van Google zo veel mogelijk inhoud van hoge kwaliteit op uw website laten crawlen, is voor de meeste website-eigenaren een primaire zorg.

Google besteedt echter slechts een beperkte hoeveelheid crawl budget en crawlsnelheid op afzonderlijke sites. De crawlsnelheid is het aantal verzoeken per seconde dat Googlebot bij uw site indient tijdens het crawlevenement.

Belangrijker is het crawlbudget, en dat is hoeveel totale verzoeken die Googlebot zal doen om uw site in één sessie te crawlen. Google 'besteedt' zijn crawlbudget door zich te concentreren op delen van uw site die erg populair zijn of recent zijn gewijzigd.

U bent niet blind voor deze informatie. Als u Google Webmaster Tools bezoekt, kunt u zien hoe de crawler met uw site omgaat.

Zoals u ziet, houdt de crawler de activiteit op uw site elke dag vrijwel constant. Het doorzoekt niet alle sites, maar alleen de sites die het belangrijkst vindt.

Waarom laat het aan Googlebot over om te beslissen wat er isbelangrijk op uw site, wanneer u uw robots.txt-bestand kunt gebruiken om te vertellen wat de belangrijkste pagina's zijn? Dit voorkomt dat Googlebot tijd verspilt aan pagina's met een lage waarde op uw site.

Uw crawlbudget optimaliseren

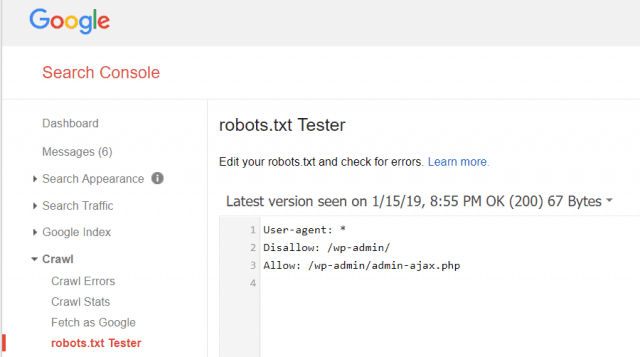

Met Google Webmaster Tools kunt u ook controleren of Googlebot uw robots.txt-bestand goed leest en of er fouten zijn.

Dit helpt u te verifiëren dat u uw robots.txt-bestand correct hebt gestructureerd.

Welke pagina's moet u niet toestaan van Googlebot? Het is goed voor uw site-SEO om de volgende categorieën pagina's niet toe te staan.

- Dubbele pagina's (zoals printervriendelijke pagina's)

- Bedankt pagina's na op formulieren gebaseerde bestellingen

- Bestel- of informatiequeryformulieren

- Contactpagina's

- Login pagina's

- Loodmagneet “verkoop” pagina's

Negeer uw Robots.txt-bestand niet

De grootste fout die nieuwe website-eigenaren maken iszelfs nooit naar hun robots.txt-bestand. De ergste situatie kan zijn dat het robots.txt-bestand uw site of delen van uw site helemaal blokkeert.

Controleer uw robots.txt-bestand en zorg ervoor dat het is geoptimaliseerd. Op deze manier 'zien' Google en andere belangrijke zoekmachines alle fantastische dingen die u de wereld aanbiedt met uw website.

![Word lid van een Active Directory Windows Domain met Windows 7 of Vista [How-To]](/images/vista/join-an-active-directory-windows-domain-with-windows-7-or-vista-how-to.png)

laat een reactie achter