מה הקובץ Robots.txt בתחום?

אחת הטעויות הגדולות ביותר עבור בעלי אתרים חדשים היא לא לבדוק את קובץ ה- robots.txt שלהם. אז מה זה בכל מקרה, ומדוע כל כך חשוב? יש לנו את התשובות שלך.

אם יש לך אתר ואכפת לך מהאתר שלךSEO בריאות, עליכם להכיר את עצמכם היטב לקובץ robots.txt בתחום שלכם. תאמינו או לא, מדובר במספר גבוה באופן מטריד של אנשים שמשיקים במהירות תחום, מתקינים אתר וורדפרס מהיר ולעולם לא טורחים לעשות שום דבר עם קובץ robots.txt שלהם.

זה מסוכן. קובץ robots.txt מוגדר בצורה לא טובה יכול למעשה להרוס את בריאות SEO של האתר שלך, ולפגוע בסיכויים שיש לך להגדיל את התנועה שלך.

מה הקובץ Robots.txt?

ה Robots.txt שם קובץ מתאים כי הוא בעצם קובץקובץ המפרט הוראות לרובוטי האינטרנט (כמו רובוטים של מנועי חיפוש) לגבי אופן יכולתם לסרוק באתר האינטרנט שלך. זה היה תקן אינטרנט ואחריו אתרים מאז 1994 וכל סורקי האינטרנט הגדולים עומדים בתקן.

הקובץ מאוחסן בפורמט טקסט (עם.סיומת txt) בתיקיית השורש של אתר האינטרנט שלך. למעשה, אתה יכול להציג את קובץ ה- robot.txt של כל אתר פשוט על ידי הקלדת הדומיין ואחריו /robots.txt. אם תנסה את זה עם groovyPost, תראה דוגמה לקובץ robot.txt מובנה היטב.

הקובץ פשוט אך יעיל. קובץ דוגמה זה אינו מבדיל בין רובוטים. הפקודות מונפקות לכל הרובוטים באמצעות ה- סוכן משתמש: * הנחיה. משמעות הדבר היא כי כל הפקודות העוקבות אחריה חלות על כל הרובוטים שמבקרים באתר כדי לסרוק אותו.

ציון סורקי רשת

תוכל גם לציין כללים ספציפיים עבורסורקי אינטרנט ספציפיים. לדוגמה, אתה עשוי לאפשר ל- Googlebot (הסורק באינטרנט של Google) לסרוק את כל המאמרים באתר שלך, אך ייתכן שתרצה לאפשר לסורק האינטרנט הרוסי Yandex Bot לסרוק מאמרים באתר שלך שיש בהם מידע מזלזל על רוסיה.

ישנם מאות סורקי רשת שגורמים לאינטרנט למידע על אתרי אינטרנט, אך עשרת הנפוצים ביותר שכדאי לדאוג אליהם מופיעים כאן.

- Googlebot: מנוע החיפוש של גוגל

- Bingbot: מנוע החיפוש Bing של מיקרוסופט

- סליפמנוע חיפוש של יאהו

- DuckDuckBot: מנוע חיפוש של DuckDuckGo

- Baiduspider: מנוע חיפוש באידו סיני

- YandexBot: מנוע חיפוש Yandex הרוסי

- Exabot: מנוע חיפוש בצרפתית Exalead

- Facebot: בוט הסריקה של פייסבוק

- ia_archiver: הסורק של דירוג האינטרנט של אלכסה

- MJ12 בוט: מסד נתונים לאינדקס קישורים גדול

אם תרצה, ניקח את התרחיש לדוגמה לעילכדי לאפשר ל- Googlebot להוסיף לאינדקס את כל מה שבאתר שלך, אך רצתה לחסום את Yandex לאינדקס של תוכן המאמר מבוסס רוסית שלך, תוסיף את השורות הבאות לקובץ robots.txt שלך.

User-agent: googlebot

Disallow: Disallow: /wp-admin/

Disallow: /wp-login.php

User-agent: yandexbot

Disallow: Disallow: /wp-admin/

Disallow: /wp-login.php

Disallow: /russia/

כפי שאתה יכול לראות, החלק הראשון רק חוסםGoogle מסריקת דף הכניסה שלך ודפי הניהול של WordPress. החלק השני חוסם את Yandex מאותו דבר, אך גם את כל האזור באתר שלך בו פרסמת מאמרים עם תוכן אנטי-רוסיה.

זו דוגמא פשוטה לאופן השימוש באפשרות בטל פקודה לשלוט בסורקי אתרים ספציפיים המבקרים באתר שלך.

פקודות Robots.txt אחרות

Disallow אינה הפקודה היחידה שיש לך גישה אליה בקובץ robots.txt. אתה יכול גם להשתמש בכל אחת מהפקודות האחרות שתכוון כיצד רובוט יכול לסרוק את האתר שלך.

- בטל: אומר לסוכן המשתמש להימנע מסריקת כתובות אתרים ספציפיות, או קטעים שלמים באתר שלך.

- להתיר: מאפשר לך לכוונן דפים או תיקיות משנה ספציפיים באתר שלך, למרות שאולי לא אישרת את תיקיית האב. לדוגמה, באפשרותך לאפשר: / בערך /, אך לאפשר: / אודות / ryan /.

- עיכוב זחילה: זה אומר לסורק להמתין מספר x שניות לפני שהוא מתחיל לסרוק את תוכן האתר.

- מפת האתר: ספק למנועי חיפוש (Google, Ask, Bing ו- Yahoo) את המיקום של מפות ה- XML שלך.

זכור כי בוטים יעשו זאת רק האזן לפקודות שסיפקת כשאתה מציין את שם הבוט.

טעות נפוצה שאנשים מבצעים היא אי-אסור לאזורים כמו / wp-admin / מכל הבוטים, אך לאחר מכן ציין קטע googlebot ורק אי-אסור לאזורים אחרים (כמו / בערך /).

מכיוון שהבוטים עוקבים רק אחר הפקודות שאתה מציין בקטע שלהם, עליך לשנות מחדש את כל הפקודות האחרות שציינת עבור כל הבוטים (באמצעות * user-agent).

- בטל: הפקודה נהגה לומר לסוכן משתמש שלא לסרוק כתובת URL מסוימת. רק שורה אחת "הרשה:" מותרת לכל כתובת אתר.

- אפשר (ישים רק עבור Googlebot): הפקודה להגיד ל- Googlebot שהיא יכולה לגשת לדף או לתיקיית משנה למרות שדף האם או תיקיית המשנה שלה עשויים להיות אסורים.

- עיכוב זחילה: כמה שניות צריך לסורק להמתין לפני שהוא טוען וסרוק תוכן עמוד. שים לב ש- Googlebot לא מאשר פקודה זו, אך ניתן להגדיר את קצב הסריקה במסוף החיפוש של Google.

- מפת האתר: משמש לקריאת המיקום של מפת אתר XML המשויך לכתובת אתר זו. שים לב פקודה זו נתמכת רק על ידי Google, Ask, Bing ו- Yahoo.

זכור כי robots.txt נועד לעזור לבוטים לגיטימיים (כמו בוטים של מנועי חיפוש) לסרוק את האתר שלך בצורה יעילה יותר.

יש שם הרבה סורקים מפחידיםהסורקים את האתר שלך כדי לעשות דברים כמו לגרד כתובות דוא"ל או לגנוב את התוכן שלך. אם אתה רוצה לנסות להשתמש בקובץ robots.txt שלך כדי לחסום את הסורקים האלה לסרוק כל דבר באתר שלך, אל תטרח. יוצרי הסורקים הללו מתעלמים בדרך כלל מכל מה ששמת בקובץ robots.txt שלך.

מדוע לא לאסור דבר?

הגדרת מנוע החיפוש של גוגל לסרוק כמה שיותר תוכן באיכות באתר האינטרנט שלך, מהווה דאגה ראשונה עבור רוב בעלי האתרים.

עם זאת, גוגל רק מוציאה מוגבלת תקציב זחילה ו קצב זחילה באתרים בודדים. שיעור הסריקה הוא כמה בקשות בשנייה שתבצע Googlebot לאתר שלך במהלך אירוע הסריקה.

חשוב יותר הוא תקציב הסריקה, וככהבקשות סה"כ רבות ש- Googlebot תבקש לסרוק את האתר שלך בפגישה אחת. גוגל "מוציאה" את תקציב הסריקה שלה על ידי התמקדות באזורים באתר שלך שהם פופולריים מאוד או שהשתנו לאחרונה.

אינך עיוור למידע זה. אם אתה מבקר בכלי מנהלי האתרים של Google, אתה יכול לראות כיצד הסורק מטפל באתר שלך.

כפי שאתה יכול לראות, הסורק שומר על פעילותו באתר שלך די קבועה מדי יום. זה לא סורק את כל האתרים, אלא רק את האתרים שהוא רואה בהם החשובים ביותר.

מדוע להשאיר ל- Googlebot להחליט מה קורהחשוב באתר שלך, כאשר אתה יכול להשתמש בקובץ robots.txt שלך כדי לומר לו מהם הדפים החשובים ביותר? זה ימנע מ- Googlebot לבזבז זמן על דפים בעלי ערך נמוך באתר שלך.

מיטוב תקציב הסריקה שלך

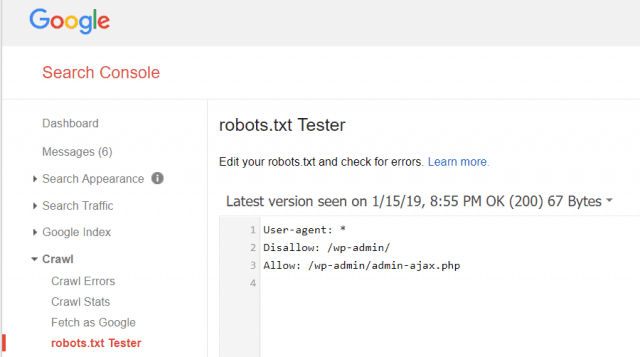

כלי מנהלי האתרים של גוגל מאפשר לך גם לבדוק אם Googlebot קורא את קובץ ה- robots.txt שלך בסדר והאם יש שגיאות.

זה עוזר לך לאמת שבנית נכון את קובץ ה- robots.txt שלך.

אילו דפים עליך לבטל מ- Googlebot? זה טוב עבור קידום אתרים באתר שלך לאפשר את הקטגוריות הבאות של דפים.

- דפים משוכפלים (כמו דפים ידידותיים להדפסה)

- דפי תודה שעוקבים אחר הזמנות מבוססות טפסים

- טפסי שאילתת הזמנה או מידע

- דפי קשר

- דפי כניסה

- דפי מכירות של מגנט עופרת

אל תתעלם מקובץ ה- Robots.txt שלך

הטעות הגדולה ביותר שבעלי אתרים חדשים עושיםאף פעם לא מסתכל בקובץ robots.txt שלהם. המצב הגרוע ביותר יכול להיות שקובץ robots.txt למעשה חוסם את האתר שלך, או אזורים באתר שלך, לסרוק בכלל.

הקפד לבדוק את קובץ robots.txt שלך וודא שהוא ממוטב. בדרך זו, גוגל ומנועי חיפוש חשובים אחרים "רואים" את כל הדברים הנהדרים שאתה מציע לעולם באמצעות אתר האינטרנט שלך.

![הצטרף לתחום Active Directory של Windows עם Windows 7 או Vista [כיצד לבצע]](/images/vista/join-an-active-directory-windows-domain-with-windows-7-or-vista-how-to.png)

השאר תגובה