Mikä on verkkotunnuksen Robots.txt-tiedosto?

Yksi uusien verkkosivustojen omistajien suurimmista virheistä ei ole robots.txt-tiedoston tutkiminen. Joten mikä se on joka tapauksessa, ja miksi niin tärkeä? Meillä on vastauksesi.

Jos omistat verkkosivuston ja välität sivustostasiSEO-terveys, sinun tulee tuntea itsesi hyvin verkkotunnuksesi robots.txt-tiedostoon. Usko tai älä, nämä ovat häiritsevästi paljon ihmisiä, jotka käynnistävät nopeasti verkkotunnuksen, asentavat nopean WordPress-verkkosivuston eivätkä koskaan vaivaudu tekemään mitään robots.txt-tiedostollaan.

Tämä on vaarallista. Huonosti konfiguroitu robots.txt-tiedosto voi tosiasiassa tuhota sivustosi SEO-terveyden ja vahingoittaa mahdollisia mahdollisuuksia kasvattaa liikennettä.

Mikä on Robots.txt-tiedosto?

Ja Robots.txt tiedosto on nimetty osuvasti, koska se on pohjimmiltaan atiedosto, joka luettelee web-robotien (kuten hakukoneiden robotit) ohjeita siitä, kuinka ja mitä ne voivat indeksoida verkkosivustollasi. Tämä on ollut verkkostandardi, jota ovat seuranneet verkkosivustot vuodesta 1994, ja kaikki suuret verkkoindeksoijat noudattavat tätä standardia.

Tiedosto tallennetaan tekstimuodossa (.txt-laajennus) verkkosivustosi juurikansioon. Itse asiassa voit tarkastella minkä tahansa verkkosivuston robot.txt-tiedostoa kirjoittamalla verkkotunnuksen ja /robots.txt. Jos kokeilet tätä groovyPost-sovelluksen kanssa, näet esimerkin hyvin jäsennellystä robot.txt-tiedostosta.

Tiedosto on yksinkertainen, mutta tehokas. Tämä esimerkitiedosto ei erota robotteja. Komennot annetaan kaikille roboteille käyttämällä Käyttäjä agentti: * direktiivi. Tämä tarkoittaa, että kaikki sitä seuraavat komennot koskevat kaikkia robotteja, jotka käyvät sivustolla indeksoimaan sitä.

Web-indeksointirobotien määrittäminen

Voit myös määrittää erityiset säännöttietyt verkkoindeksoijat. Voit esimerkiksi sallia Googlebotin (Googlen verkkoindeksoijan) indeksoida kaikki sivustosi artikkelit, mutta saatat haluta estää venäläistä web-indeksoijaa Yandex Botia indeksoimasta sivustosi artikkeleita, joissa on halventavaa tietoa Venäjästä.

On satoja verkkoindeksoijia, jotka hakevat tietoa verkkosivustoista, mutta tässä luetellaan 10 yleisintä, joista sinun pitäisi olla huolissasi.

- googlebot: Google-hakukone

- Bingbot: Microsoftin Bing-hakukone

- Ryystää: Yahoo-hakukone

- DuckDuckBot: DuckDuckGo-hakukone

- Baiduspider: Kiinalainen Baidu-hakukone

- YandexBot: Venäjän Yandex-hakukone

- Exabot: Ranskan Exalead-hakukone

- Facebot: Facebookin indeksointirobotti

- ia_archiver: Alexan web-indeksointirobotti

- MJ12bot: Suuri linkkien indeksointitietokanta

Otetaan yllä oleva esimerkki, jos haluatlisäämään seuraavat rivit robots.txt-tiedostoon, jotta Googlebot voi indeksoida kaiken sivustosi sisällön, mutta halusi estää Yandexia indeksoimasta venäläistä artikkelisisältöäsi.

User-agent: googlebot

Disallow: Disallow: /wp-admin/

Disallow: /wp-login.php

User-agent: yandexbot

Disallow: Disallow: /wp-admin/

Disallow: /wp-login.php

Disallow: /russia/

Kuten näette, ensimmäinen osa vain estääGoogle indeksoi WordPress-kirjautumissivusi ja järjestelmänvalvojasivusi. Toinen jakso estää Yandexia samasta, mutta myös koko sivustosi alueelta, jolla olet julkaissut Venäjän vastaisen sisällön artikkeleita.

Tämä on yksinkertainen esimerkki siitä, kuinka voit käyttää Estä -komento, jolla voit hallita tiettyjä verkkosivustoasi käyviä indeksointirobotteja.

Muut Robots.txt-komennot

Disallow ei ole ainoa komento, johon sinulla on pääsy robots.txt-tiedostoon. Voit käyttää myös mitä tahansa muita komentoja, jotka ohjaavat, kuinka robotti voi indeksoida sivustosi.

- Estä: Kehottaa käyttäjän edustajaa välttämään tiettyjen URL-osoitteiden tai kokonaisten sivustosi osien indeksointia.

- Sallia: Voit hienosäätää tiettyjä sivustosi sivuja tai alikansiota, vaikka olet estänyt vanhempien kansioiden. Voit esimerkiksi estää: / noin /, mutta sallia sitten: / about / ryan /.

- Ryömiä-viive: Tämä käskee indeksoijaa odottamaan xx sekuntimäärä ennen kuin selaa sivuston sisältöä.

- Sivukartta: Anna hakukoneille (Google, Ask, Bing ja Yahoo) XML-sivustokarttasi sijainti.

Muista, että robotit tulevat vain kuuntele antamasi komennot, kun määrität robotin nimen.

Yleinen virhe, jonka ihmiset tekevät, on sellaisten alueiden, kuten / wp-admin /, kieltäminen kaikista boteista, mutta määritä sitten googlebot-osio ja vain muiden alueiden (kuten / noin /) kieltäminen.

Koska robotit seuraavat vain niiden osiossa määrittämiäsi komentoja, sinun on uusittava kaikki ne muut, jotka olet määrittänyt kaikille robotille (käyttämällä * user-agenttia).

- Estä: Komento, jota käytetään käyttäjien edustajalle käskää olla indeksoimatta tiettyä URL-osoitetta. Kullekin URL-osoitteelle on sallittu vain yksi Dishibition: -rivi.

- Salli (koskee vain Googlebotia): Komento kertoa Googlebotille, että se voi käyttää sivua tai alikansiota, vaikka sen emo- tai alikansiot voidaan estää.

- Ryömiä-viive: Kuinka monta sekuntia indeksoijan tulee odottaa ennen sivun sisällön lataamista ja indeksointia. Huomaa, että Googlebot ei tunnista tätä komentoa, mutta indeksointinopeuden voi asettaa Google Search Consolessa.

- Sivukartta: Käytetään tähän URL-osoitteeseen liittyvien XML-sivustokarttojen sijaintiin. Huomaa, että tätä komentoa tukevat vain Google, Ask, Bing ja Yahoo.

Muista, että robots.txt on tarkoitettu auttamaan laillisia robotteja (kuten hakukoneiden robotteja) indeksoimaan sivustosi tehokkaammin.

Siellä on paljon kurja indeksoijiajotka indeksoivat sivustoasi tehdäksesi esimerkiksi kaapia sähköpostiosoitteita tai varastaa sisältöäsi. Älä häiritse, jos haluat kokeilla robots.txt-tiedostoasi estääksesi indeksoijaa indeksoimasta mitään sivustoltasi. Indeksoijien luojat jättävät tyypillisesti huomiotta kaiken, mitä olet lisännyt robots.txt-tiedostoosi.

Miksi estää mitään?

Useimpien verkkosivustojen omistajien ensisijainen huolenaihe on saada Google-hakukone indeksoimaan mahdollisimman paljon laadukasta sisältöä verkkosivustollesi.

Google käyttää kuitenkin vain rajoitetusti indeksoida budjetti ja indeksointinopeus yksittäisillä sivustoilla. Indeksointinopeus on se, kuinka monta pyyntöä sekunnissa Googlebot tekee sivustollesi indeksointitapahtuman aikana.

Tärkeämpää on indeksointibudjetti, mitenGooglebot tekee useita pyyntöjä indeksoidaksesi sivustosi yhdessä istunnossa. Google “viettää” indeksointbudjettinsa keskittymällä sivustosi alueille, jotka ovat erittäin suosittuja tai muuttuneet viime aikoina.

Et ole sokea näiden tietojen suhteen. Jos käyt Google-verkkovastaavan työkaluissa, näet kuinka indeksointirobotti käsittelee sivustoasi.

Kuten huomaat, indeksoija indeksoi sivustosi toimintaa melko vakiona joka päivä. Se ei indeksoi kaikkia sivustoja, vaan vain niitä, joita se pitää tärkeimpinä.

Miksi antaa Googlebotille päättää, mikä onon tärkeä sivustoltasi, kun robots.txt-tiedostosi voi kertoa sille, mitkä ovat tärkeimmät sivut? Tämä estää Googlebotia tuhlaamasta aikaa sivustosi vähäarvoisille sivuille.

Indeksointibudjettisi optimointi

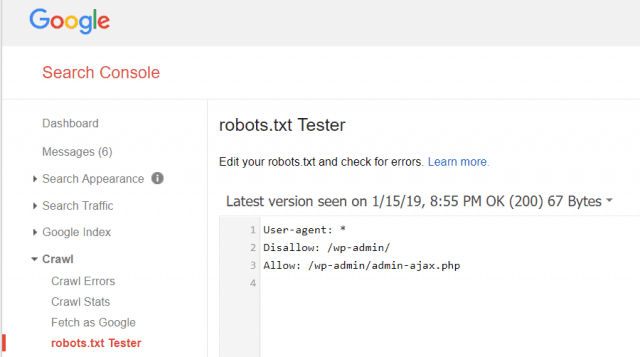

Google-verkkovastaavan työkalujen avulla voit myös tarkistaa, lukeeko Googlebot robots.txt-tiedostoasi oikein ja onko virheitä.

Tämä auttaa sinua tarkistamaan, että olet järjestänyt robots.txt-tiedostosi oikein.

Mitkä sivut sinun tulisi estää Googlebotista? On hyvä, että sivustosi SEO kieltää seuraavat sivukategoriat.

- Kopioidut sivut (kuten tulostinystävälliset sivut)

- Kiitos sivuja, jotka seuraavat lomakepohjaisia tilauksia

- Tilaus- tai tietokyselylomakkeet

- Yhteystiedot

- Sisäänkirjautumissivut

- Johtava magneetti ”myynti” -sivut

Älä ohita Robots.txt-tiedostoasi

Suurin uusien verkkosivustojen omistajien virhe onkoskaan edes tarkastelemalla heidän robots.txt-tiedostoaan. Pahimmassa tilanteessa voi olla, että robots.txt-tiedosto todella estää sivustosi tai sivustosi alueiden indeksointia.

Muista tarkistaa robots.txt-tiedostosi ja varmistaa, että se on optimoitu. Tällä tavalla Google ja muut tärkeät hakukoneet "näkevät" kaikki ne upeat asiat, joita tarjoat maailmalle verkkosivustosi kanssa.

![Liity Active Directory -toimialueen Windows 7 tai Vista kanssa [Ohjeet]](/images/vista/join-an-active-directory-windows-domain-with-windows-7-or-vista-how-to.png)

Jätä kommentti