Hvad er Robots.txt-filen i et domæne?

En af de største fejl for nye webstedsejere er ikke at undersøge deres robots.txt-fil. Så hvad er det alligevel, og hvorfor så vigtigt? Vi har dine svar.

Hvis du ejer et websted og er interesseret i dit webstedSEO-sundhed, du skal gøre dig meget bekendt med filen robots.txt på dit domæne. Tro det eller ej, det er et foruroligende stort antal mennesker, der hurtigt starter et domæne, installerer et hurtigt WordPress-websted og aldrig gider at gøre noget med deres robots.txt-fil.

Dette er farligt. En dårligt konfigureret robots.txt-fil kan faktisk ødelægge dit websteds SEO-helbred og ødelægge eventuelle chancer, du måtte have for at øge din trafik.

Hvad er Robots.txt-filen?

Det Robots.txt filen er passende navngivet, fordi den egentlig er enfil, der viser direktiver for webrobotterne (som søgemaskinerobotter) om, hvordan og hvad de kan gennemgå på dit websted. Dette har været en webstandard efterfulgt af websteder siden 1994, og alle større webcrawlere overholder standarden.

Filen gemmes i tekstformat (med en.txt-udvidelse) på rodmappen på dit websted. Faktisk kan du se ethvert websteds robot.txt-fil bare ved at skrive domænet efterfulgt af /robots.txt. Hvis du prøver dette med groovyPost, ser du et eksempel på en godt struktureret robot.txt-fil.

Filen er enkel, men effektiv. Denne eksempelfil adskiller ikke mellem robotter. Kommandoerne udstedes til alle robotter ved hjælp af Bruger-agent: * direktiv. Dette betyder, at alle kommandoer, der følger det, gælder for alle robotter, der besøger stedet for at gennemgå det.

Specificering af webcrawlers

Du kan også specificere specifikke regler forspecifikke webcrawlere. For eksempel kan du muligvis tillade Googlebot (Googles webcrawler) at gennemgå alle artikler på dit websted, men du vil måske afvise den russiske webcrawler Yandex Bot fra at gennemgå artikler på dit websted, der har nedværdende oplysninger om Rusland.

Der er hundreder af webcrawlere, der søger internettet for information om websteder, men de 10 mest almindelige du skal være bekymrede over er listet her.

- Googlebot: Google-søgemaskine

- Bingbot: Microsofts Bing-søgemaskine

- slubre: Yahoo-søgemaskine

- DuckDuckBot: DuckDuckGo søgemaskine

- Baiduspider: Kinesisk Baidu-søgemaskine

- YandexBot: Russisk Yandex søgemaskine

- Exabot: Fransk Exalead søgemaskine

- Facebot: Facebooks gennemsøgende bot

- ia_archiver: Alexa's webrangørcrawler

- MJ12bot: Stor link indekseringsdatabase

Tag eksemplet ovenfor, hvis du vilfor at give Googlebot mulighed for at indeksere alt på dit websted, men ønskede at blokere Yandex fra at indeksere dit russisk baserede artikelindhold, tilføjede du følgende linjer til din robots.txt-fil.

User-agent: googlebot

Disallow: Disallow: /wp-admin/

Disallow: /wp-login.php

User-agent: yandexbot

Disallow: Disallow: /wp-admin/

Disallow: /wp-login.php

Disallow: /russia/

Som du kan se, blokerer det første afsnit kunGoogle fra at gennemgå din WordPress login-side og administrative sider. Det andet afsnit blokerer Yandex for det samme, men også for hele området på dit websted, hvor du har offentliggjort artikler med anti-Rusland-indhold.

Dette er et simpelt eksempel på, hvordan du kan bruge Disallow kommando til at kontrollere specifikke webcrawlere, der besøger dit websted.

Andre Robots.txt-kommandoer

Disallow er ikke den eneste kommando, du har adgang til i din robots.txt-fil. Du kan også bruge en hvilken som helst af de andre kommandoer, der styrer, hvordan en robot kan gennemgå dit websted.

- Disallow: Fortæller brugeragenten om at undgå gennemsøgning af specifikke webadresser eller hele sektioner af dit websted.

- Tillade: Giver dig mulighed for at finjustere bestemte sider eller undermapper på dit websted, selvom du muligvis har afvist en overordnet mappe. For eksempel kan du afvise: / om /, men derefter tillade: / om / ryan /.

- Forsinket gennemgang: Dette fortæller webcrawleren at vente xx antal sekunder, før den begynder at gennemgå webstedets indhold.

- Sitemap: Angiv søgemaskiner (Google, Ask, Bing og Yahoo) placeringen af dine XML-sitemaps.

Husk, at bots vil gøre det kun lyt til de kommandoer, du har givet, når du specificerer navnet på bot.

En almindelig fejl, som folk begår, er at afvise områder som / wp-admin / fra alle bots, men angiv derefter et googlebot-afsnit og kun at afvise andre områder (som / om /).

Da bots kun følger de kommandoer, du angiver i deres afsnit, skal du ændre alle disse andre kommandoer, som du har angivet for alle bots (ved hjælp af * brugeragenten).

- Disallow: Kommandoen brugt til at fortælle en brugeragent om ikke at gennemgå en bestemt URL. Kun en “Disallow:” -linie er tilladt for hver URL.

- Tillad (gælder kun for Googlebot): Kommandoen til at fortælle Googlebot, at den kan få adgang til en side eller undermappe, selvom dens forældreside eller undermappe muligvis er tilladt.

- Forsinket gennemgang: Hvor mange sekunder skal en crawler vente, inden indlæsning og gennemsøgning af sideindhold. Bemærk, at Googlebot ikke anerkender denne kommando, men der kan indstilles gennemsøgningshastighed i Google Search Console.

- Sitemap: Bruges til at kalde placeringen af et XML-sitemap (er), der er knyttet til denne URL. Bemærk, at denne kommando kun understøttes af Google, Ask, Bing og Yahoo.

Husk, at robots.txt er beregnet til at hjælpe legitime bots (som søgemaskinebots) gennemgå dit websted mere effektivt.

Der er masser af uærlige crawlere derudeder gennemsøger dit websted for at gøre ting som at skrabe e-mail-adresser eller stjæle dit indhold. Hvis du vil prøve at bruge din robots.txt-fil til at blokere disse crawler fra at gennemgå noget på dit websted, skal du ikke gider. Oprettelsen af disse crawlere ignorerer typisk alt, hvad du har lagt i din robots.txt-fil.

Hvorfor afvise noget?

At få Googles søgemaskine til at gennemgå så meget kvalitetsindhold på dit websted som muligt er en primær bekymring for de fleste webstedsejere.

Google udvider dog kun et begrænset gennemsøgningsbudget og gennemsøgningshastighed på individuelle websteder. Gennemsøgningshastigheden er, hvor mange anmodninger pr. Sekund Googlebot fremsætter til dit websted under crawle-begivenheden.

Mere vigtigt er gennemsøgningsbudgettet, hvilket er sådanmange samlede anmodninger fra Googlebot om at gennemgå dit websted i en session. Google "bruger" sit gennemsøgningsbudget ved at fokusere på områder på dit websted, der er meget populære eller har ændret sig for nylig.

Du er ikke blind for disse oplysninger. Hvis du besøger Google Webmasterværktøjer, kan du se, hvordan webcrawleren håndterer dit websted.

Som du kan se, holder crawlen sin aktivitet på dit websted temmelig konstant hver dag. Det gennemsøger ikke alle websteder, men kun de, det anser for at være de vigtigste.

Hvorfor overlade det til Googlebot at beslutte, hvad der skervigtigt på dit websted, når du kan bruge din robots.txt-fil til at fortælle den, hvad de vigtigste sider er? Dette forhindrer Googlebot i at spilde tid på sider med lav værdi på dit websted.

Optimering af dit gennemsøgningsbudget

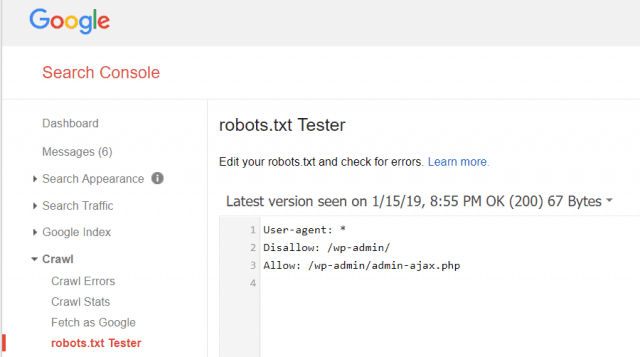

Google Webmasterværktøjer giver dig også mulighed for at kontrollere, om Googlebot læser din robots.txt-fil fint, og om der er fejl.

Dette hjælper dig med at bekræfte, at du har struktureret din robots.txt-fil korrekt.

Hvilke sider skal du afvise fra Googlebot? Det er godt for dit websteds SEO at afvise følgende kategorier af sider.

- Kopier sider (som printervenlige sider)

- Tak sider, der følger formularbaserede ordrer

- Bestillings- eller informationsforespørgselsformularer

- Kontaktsider

- Login sider

- Lead magnet “salg” sider

Ignorer ikke din Robots.txt-fil

Den største fejl, som nye webstedsejere begår, eraldrig selv se på deres robots.txt-fil. Den værste situation kan være, at robots.txt-filen faktisk blokerer dit websted eller områder på dit websted fra at blive gennemsøgt overhovedet.

Sørg for at gennemgå din robots.txt-fil, og sørg for, at den er optimeret. På denne måde "se" Google og andre vigtige søgemaskiner alle de fantastiske ting, du tilbyder verden med dit websted.

![Deltag i et Active Directory Windows-domæne med Windows 7 eller Vista [Sådan gør du]](/images/vista/join-an-active-directory-windows-domain-with-windows-7-or-vista-how-to.png)

Efterlad en kommentar