ما هو ملف Robots.txt في المجال؟

واحدة من أكبر الأخطاء لمالكي مواقع الويب الجديدة لا تبحث في ملف robots.txt الخاص بهم. فما هو على أي حال ، ولماذا مهم جدا؟ لدينا إجاباتك.

إذا كنت تمتلك موقع ويب وتهتم بموقعكصحة مُحسّنات محرّكات البحث ، يجب أن تكون على دراية بملف robots.txt على نطاقك. صدق أو لا تصدق ، هذا عدد كبير بشكل مثير للقلق من الأشخاص الذين يطلقون المجال بسرعة ، ويقومون بتثبيت موقع ويب WordPress سريع ، ولا يكلف نفسه عناء القيام بأي شيء باستخدام ملف robots.txt الخاص بهم.

هذا أمر خطير. يمكن لملف robots.txt الذي تم تكوينه بشكل سيء أن يدمر بالفعل صحة مُحسّنات محرّكات البحث الخاصة بموقعك ، وقد يتسبب في إتلاف أي فرص قد تتسبب في زيادة عدد الزيارات لديك.

ما هو ملف Robots.txt؟

ال Robots.txt تم تسمية الملف على نحو مناسب لأنه أساسيملف يسرد التوجيهات الخاصة بروبوتات الويب (مثل روبوتات محرك البحث) حول كيفية وما يمكنهم الزحف إليه على موقع الويب الخاص بك. لقد كان هذا معيارًا على الويب يتبعه مواقع الويب منذ عام 1994 وتلتزم جميع برامج زحف الويب الرئيسية بهذا المعيار.

يتم تخزين الملف في تنسيق النص (مع.تمديد النص) على المجلد الجذر لموقع الويب الخاص بك. في الواقع ، يمكنك عرض ملف robot.txt لأي موقع ويب فقط عن طريق كتابة النطاق متبوعًا بـ /robots.txt. إذا جربت ذلك باستخدام groovyPost ، فسترى مثالًا على ملف robot.txt منظم جيدًا.

الملف بسيط لكنه فعال. ملف المثال هذا لا يفرق بين الروبوتات. يتم إصدار الأوامر لجميع الروبوتات باستخدام وكيل المستخدم: * التوجيه. هذا يعني أن جميع الأوامر التي تتبعه تنطبق على جميع الروبوتات التي تزور الموقع للزحف إليه.

تحديد زواحف الويب

يمكنك أيضا تحديد قواعد محددة لزواحف الويب المحددة. على سبيل المثال ، قد تسمح لـ Googlebot (زاحف الويب من Google) بالزحف إلى جميع المقالات الموجودة على موقعك ، ولكن قد ترغب في عدم السماح لبرنامج زاحف الويب الروسي Yandex Bot من الزحف إلى المقالات الموجودة على موقعك والتي تحط من قدر معلومات روسيا.

هناك المئات من برامج زحف الويب التي تبحث في الإنترنت للحصول على معلومات حول مواقع الويب ، ولكن يتم سرد أكثر 10 برامج بحث يجب أن تكون مهتمًا بها.

- برنامج Googlebot: محرك بحث جوجل

- Bingbot: محرك بحث Microsoft Bing

- كرطع: محرك بحث Yahoo

- DuckDuckBot: محرك البحث DuckDuckGo

- Baiduspider: الصينية محرك البحث بايدو

- YandexBot: محرك بحث Yandex الروسي

- Exabot: الفرنسية محرك البحث Exalead

- Facebot: الفيسبوك الزحف الروبوت

- ia_archiver: الزاحف ترتيب الويب اليكسا

- MJ12bot: قاعدة بيانات كبيرة فهرسة الارتباط

أخذ السيناريو المثال أعلاه ، إذا كنت تريدللسماح لـ Googlebot بفهرسة كل شيء على موقعك ، ولكنك أردت منع Yandex من فهرسة محتوى مقالك الروسي ، فأنت تضيف الأسطر التالية إلى ملف robots.txt الخاص بك.

User-agent: googlebot

Disallow: Disallow: /wp-admin/

Disallow: /wp-login.php

User-agent: yandexbot

Disallow: Disallow: /wp-admin/

Disallow: /wp-login.php

Disallow: /russia/

كما ترون ، القسم الأول كتل فقطجوجل من الزحف إلى صفحة تسجيل الدخول الخاصة بك ووردبرس] والصفحات الإدارية. يحظر القسم الثاني Yandex من نفسه ، ولكن أيضًا من المنطقة بأكملها من موقعك حيث نشرت مقالات ذات محتوى مناهض لروسيا.

هذا مثال بسيط على كيفية استخدام عدم السماح أمر للتحكم في برامج زحف الويب المحددة التي تزور موقع الويب الخاص بك.

أوامر Robots.txt الأخرى

عدم السماح ليس هو الأمر الوحيد الذي يمكنك الوصول إليه في ملف robots.txt. يمكنك أيضًا استخدام أي من الأوامر الأخرى التي ستوجه كيفية قيام الروبوت بالزحف إلى موقعك.

- عدم السماح: أخبر وكيل المستخدم بتجنب الزحف إلى عناوين URL محددة أو أقسام كاملة من موقعك.

- السماح: يتيح لك ضبط صفحات أو مجلدات فرعية محددة على موقعك ، على الرغم من أنك قد تكون غير مسموح بمجلد أصل. على سبيل المثال ، يمكنك عدم السماح بـ: / about / ، لكن بعد ذلك: / about / ryan /.

- الزحف التأخير: هذا يخبر الزاحف بالانتظار لعدد xx من الثواني قبل البدء في الزحف إلى محتوى الموقع.

- خريطة الموقع: قم بتزويد محركات البحث (Google و Ask و Bing و Yahoo) بموقع ملفات خرائط XML الخاصة بك.

ضع في اعتبارك أن الروبوتات سوف فقط استمع إلى الأوامر التي قدمتها عند تحديد اسم الروبوت.

من الأخطاء الشائعة التي يرتكبها الأشخاص عدم السماح لمناطق مثل / wp-admin / من جميع برامج الروبوت ، ولكن بعد ذلك حدد قسم googlebot وعدم السماح فقط للمناطق الأخرى (مثل / حول /).

نظرًا لأن برامج الروبوت تتبع فقط الأوامر التي تحددها في قسمهم ، فيجب عليك إعادة تأكيد كل تلك الأوامر الأخرى التي حددتها لجميع برامج الروبوت (باستخدام وكيل المستخدم *).

- عدم السماح: الأمر المستخدم لإخبار وكيل المستخدم بعدم الزحف إلى عنوان URL معين. يُسمح بسطر "Disallow:" واحد فقط لكل عنوان URL.

- السماح (ينطبق فقط على Googlebot): أمر إخبار Googlebot بأنه يمكنه الوصول إلى صفحة أو مجلد فرعي على الرغم من أنه قد يتم رفض الصفحة الرئيسية أو المجلد الفرعي.

- الزحف التأخير: كم ثانية يجب على الزاحف الانتظار قبل تحميل محتوى الصفحة والزحف إليه. لاحظ أن Googlebot لا يعترف بهذا الأمر ، ولكن يمكن تعيين معدل الزحف في وحدة تحكم بحث Google.

- خريطة الموقع: تستخدم للاتصال بموقع ملف (ملفات) XML لملف XML المرتبط بعنوان URL هذا. لاحظ أن هذا الأمر مدعوم فقط من قِبل Google و Ask و Bing و Yahoo.

ضع في اعتبارك أن ملف robots.txt يهدف إلى مساعدة برامج الروبوت المشروعة (مثل برامج روبوت محرك البحث) على الزحف إلى موقعك بشكل أكثر فعالية.

هناك الكثير من برامج الزحف الشائنة هناكالتي تزحف إلى موقعك للقيام بأشياء مثل كشط عناوين البريد الإلكتروني أو سرقة المحتوى الخاص بك. إذا كنت ترغب في محاولة استخدام ملف robots.txt الخاص بك لمنع برامج الزحف هذه من الزحف إلى أي شيء على موقعك ، فلا تهتم. يتجاهل منشئو برامج الزحف هذه عادة أي شيء تضعه في ملف robots.txt الخاص بك.

لماذا عدم السماح بأي شيء؟

يُعد الحصول على محرك بحث Google للزحف إلى أكبر قدر ممكن من المحتوى ذي الجودة على موقع الويب الخاص بك مصدر قلق رئيسي لمعظم مالكي مواقع الويب.

ومع ذلك ، جوجل تنفق فقط محدودة الزحف الميزانية و معدل الزحف على المواقع الفردية. معدل الزحف هو عدد الطلبات في الثانية التي يقدمها Googlebot إلى موقعك أثناء حدث الزحف.

الأهم من ذلك هو ميزانية الزحف ، والتي هي كيفالعديد من إجمالي الطلبات التي سيطلبها Googlebot للزحف إلى موقعك في جلسة واحدة. جوجل "تنفق" ميزانية الزحف الخاصة بها من خلال التركيز على المناطق التي تحظى بشعبية كبيرة أو تغيرت مؤخرا.

أنت لست عمياء عن هذه المعلومات. إذا قمت بزيارة أدوات مشرفي المواقع من Google ، يمكنك معرفة كيفية تعامل الزاحف مع موقعك.

كما ترى ، فإن الزاحف يبقي نشاطه على موقعك ثابتًا كل يوم. لا يزحف إلى جميع المواقع ، ولكن فقط تلك المواقع التي يعتبرها الأكثر أهمية.

لماذا تترك الأمر لـ Googlebot لتحديد ما هومهم على موقعك ، عندما يمكنك استخدام ملف robots.txt لتخبره عن أهم الصفحات؟ سيمنع ذلك Googlebot من إضاعة الوقت في الصفحات منخفضة القيمة على موقعك.

تحسين ميزانية الزحف الخاصة بك

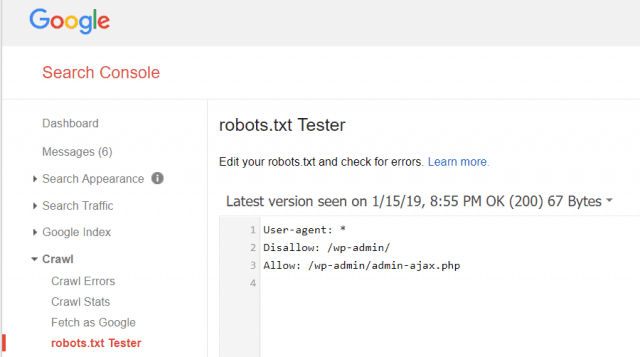

تتيح لك أدوات مشرفي المواقع من Google أيضًا التحقق مما إذا كان Googlebot يقرأ ملف robots.txt بشكل جيد وما إذا كانت هناك أية أخطاء.

يساعدك هذا في التحقق من أنك قمت بتنظيم ملف robots.txt الخاص بك بشكل صحيح.

ما الصفحات التي يجب عدم السماح بها من Googlebot؟ من الجيد أن لا يسمح لك SEO لموقعك بفئات الصفحات التالية.

- صفحات مكررة (مثل الصفحات الصديقة للطابعة)

- شكرا لك صفحات تتبع الطلبات المستندة إلى النموذج

- طلب أو نماذج الاستعلام المعلومات

- صفحات الاتصال

- صفحات تسجيل الدخول

- يؤدي المغناطيس "المبيعات" صفحات

لا تتجاهل ملف Robots.txt الخاص بك

أكبر خطأ جعل أصحاب المواقع الجديدة هولا تنظر أبدًا إلى ملف robots.txt الخاص بهم. قد يكون أسوأ موقف هو أن ملف robots.txt يحظر موقعك أو مناطق موقعك من الزحف على الإطلاق.

تأكد من مراجعة ملف robots.txt والتأكد من تحسينه. بهذه الطريقة ، ترى Google ومحركات البحث المهمة الأخرى كل الأشياء الرائعة التي تقدمها للعالم من خلال موقع الويب الخاص بك.

![انضم إلى مجال Windows Active Directory مع Windows 7 أو Vista [كيف]](/images/vista/join-an-active-directory-windows-domain-with-windows-7-or-vista-how-to.png)

اترك تعليقا