¿Qué es el archivo Robots.txt en un dominio?

Uno de los mayores errores para los nuevos propietarios de sitios web es no buscar en su archivo robots.txt. Entonces, ¿qué es de todos modos y por qué es tan importante? Tenemos sus respuestas

Si posee un sitio web y le interesanSalud de SEO, debe familiarizarse con el archivo robots.txt de su dominio. Lo creas o no, ese es un número inquietantemente alto de personas que inician rápidamente un dominio, instalan un sitio web rápido de WordPress y nunca se molestan en hacer nada con su archivo robots.txt.

Esto es peligroso. Un archivo robots.txt mal configurado en realidad puede destruir el estado de SEO de su sitio y dañar cualquier posibilidad que tenga de aumentar su tráfico.

¿Qué es el archivo Robots.txt?

los Robots.txt el archivo se llama correctamente porque es esencialmente unarchivo que enumera las directivas para los robots web (como los robots de los motores de búsqueda) sobre cómo y qué pueden rastrear en su sitio web. Este ha sido un estándar web seguido por sitios web desde 1994 y todos los principales rastreadores web se adhieren al estándar.

El archivo se almacena en formato de texto (con un.extensión txt) en la carpeta raíz de su sitio web. De hecho, puede ver el archivo robot.txt de cualquier sitio web simplemente escribiendo el dominio seguido de /robots.txt. Si prueba esto con groovyPost, verá un ejemplo de un archivo robot.txt bien estructurado.

El archivo es simple pero efectivo. Este archivo de ejemplo no diferencia entre robots. Los comandos se emiten a todos los robots mediante el uso de Agente de usuario: * directiva. Esto significa que todos los comandos que siguen se aplican a todos los robots que visitan el sitio para rastrearlo.

Especificación de rastreadores web

También puede especificar reglas específicas pararastreadores web específicos. Por ejemplo, puede permitir que Googlebot (el rastreador web de Google) rastree todos los artículos en su sitio, pero es posible que no permita que el rastreador ruso Yandex Bot rastree artículos en su sitio que tengan información despectiva sobre Rusia.

Hay cientos de rastreadores web que buscan información sobre sitios web en Internet, pero los 10 más comunes por los que debe preocuparse se enumeran aquí.

- Googlebot: Motor de búsqueda de Google

- Bingbot: Motor de búsqueda Bing de Microsoft

- Sorber: Motor de búsqueda de Yahoo

- PatoPatoBot: Motor de búsqueda DuckDuckGo

- Baiduspider: Motor de búsqueda chino Baidu

- YandexBot: Motor de búsqueda ruso Yandex

- Exabot: Motor de búsqueda francés Exalead

- Facebot: El robot rastreador de Facebook

- ia_archiver: El rastreador de rankings web de Alexa

- MJ12bot: Gran base de datos de indexación de enlaces

Tomando el escenario de ejemplo anterior, si quisieraspara permitir que Googlebot indexe todo en su sitio, pero quería impedir que Yandex indexe el contenido de su artículo basado en Rusia, debe agregar las siguientes líneas a su archivo robots.txt.

User-agent: googlebot

Disallow: Disallow: /wp-admin/

Disallow: /wp-login.php

User-agent: yandexbot

Disallow: Disallow: /wp-admin/

Disallow: /wp-login.php

Disallow: /russia/

Como puede ver, la primera sección solo bloqueaGoogle rastrea su página de inicio de sesión de WordPress y las páginas administrativas. La segunda sección bloquea Yandex de lo mismo, pero también de toda el área de su sitio donde ha publicado artículos con contenido anti-Rusia.

Este es un ejemplo simple de cómo puede usar el Rechazar comando para controlar rastreadores web específicos que visitan su sitio web.

Otros comandos de Robots.txt

No permitir no es el único comando al que tiene acceso en su archivo robots.txt. También puede usar cualquiera de los otros comandos que dirigirán cómo un robot puede rastrear su sitio.

- Rechazar: Le indica al agente de usuario que evite rastrear URL específicas o secciones completas de su sitio.

- Permitir: Le permite ajustar páginas o subcarpetas específicas en su sitio, aunque haya rechazado una carpeta principal. Por ejemplo, puede rechazar: / about /, pero luego permitir: / about / ryan /.

- Rastreo-retraso: Esto le dice al rastreador que espere xx segundos antes de comenzar a rastrear el contenido del sitio.

- Mapa del sitio: Proporcione a los motores de búsqueda (Google, Ask, Bing y Yahoo) la ubicación de sus mapas de sitio XML.

Tenga en cuenta que los bots lo harán solamente escuche los comandos que ha proporcionado cuando especifica el nombre del bot.

Un error común que comete la gente es rechazar áreas como / wp-admin / de todos los bots, pero luego especifica una sección de googlebot y solo rechaza otras áreas (como / about /).

Dado que los bots solo siguen los comandos que especifique en su sección, debe reexpresar todos los otros comandos que ha especificado para todos los bots (usando el * user-agent).

- Rechazar: El comando utilizado para decirle a un agente de usuario que no rastree una URL particular. Solo se permite una línea "No permitir:" para cada URL.

- Permitir (solo aplicable para Googlebot): El comando para decirle a Googlebot que puede acceder a una página o subcarpeta aunque su página principal o subcarpeta no esté permitida.

- Rastreo-retraso: Cuántos segundos debe esperar un rastreador antes de cargar y rastrear el contenido de la página. Tenga en cuenta que Googlebot no reconoce este comando, pero la frecuencia de rastreo se puede establecer en Google Search Console.

- Mapa del sitio: Se utiliza para indicar la ubicación de un mapa del sitio XML asociado con esta URL. Tenga en cuenta que este comando solo es compatible con Google, Ask, Bing y Yahoo.

Tenga en cuenta que el archivo robots.txt está destinado a ayudar a los bots legítimos (como los bots de los motores de búsqueda) a rastrear su sitio de manera más efectiva.

Hay muchos rastreadores nefastosque están rastreando su sitio para hacer cosas como raspar direcciones de correo electrónico o robar su contenido. Si desea probar y usar su archivo robots.txt para impedir que esos rastreadores rastreen algo en su sitio, no se moleste. Los creadores de esos rastreadores generalmente ignoran todo lo que haya puesto en su archivo robots.txt.

¿Por qué no permitir nada?

Hacer que el motor de búsqueda de Google rastree la mayor cantidad posible de contenido de calidad en su sitio web es una preocupación principal para la mayoría de los propietarios de sitios web.

Sin embargo, Google solo gasta una cantidad limitada presupuesto de rastreo y frecuencia de rastreo en sitios individuales. La frecuencia de rastreo es cuántas solicitudes por segundo realizará el robot de Google en su sitio durante el evento de rastreo.

Más importante es el presupuesto de rastreo, que es cómomuchas solicitudes totales que hará Googlebot para rastrear su sitio en una sesión. Google "gasta" su presupuesto de rastreo al enfocarse en áreas de su sitio que son muy populares o que han cambiado recientemente.

No eres ciego a esta información. Si visita las Herramientas para webmasters de Google, puede ver cómo el rastreador maneja su sitio.

Como puede ver, el rastreador mantiene su actividad en su sitio bastante constante todos los días. No rastrea todos los sitios, sino solo aquellos que considera más importantes.

¿Por qué dejar que Googlebot decida qué esimportante en su sitio, ¿cuándo puede usar su archivo robots.txt para decirle cuáles son las páginas más importantes? Esto evitará que Googlebot pierda tiempo en páginas de bajo valor en su sitio.

Optimizando su presupuesto de rastreo

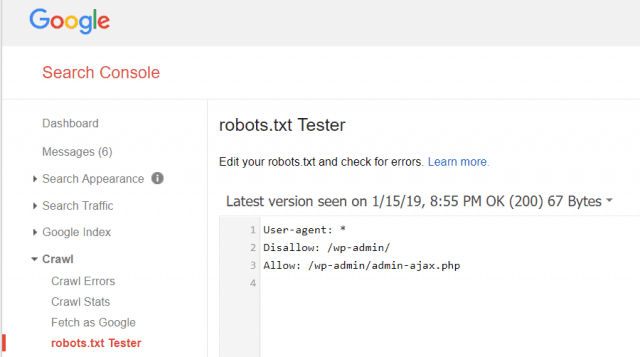

Las Herramientas para webmasters de Google también le permiten verificar si Googlebot está leyendo bien su archivo robots.txt y si hay algún error.

Esto le ayuda a verificar que ha estructurado su archivo robots.txt correctamente.

¿Qué páginas deberías rechazar de Googlebot? Es bueno que el SEO de su sitio no permita las siguientes categorías de páginas.

- Páginas duplicadas (como páginas para imprimir)

- Páginas de agradecimiento siguiendo pedidos basados en formularios

- Solicitud o formularios de consulta de información

- Paginas de contacto

- Páginas de inicio de sesión

- Páginas de "ventas" de imán de plomo

No ignore su archivo Robots.txt

El mayor error que cometen los nuevos propietarios de sitios web esni siquiera mirando su archivo robots.txt. La peor situación podría ser que el archivo robots.txt realmente esté bloqueando su sitio, o áreas de su sitio, para que no se rastree.

Asegúrese de revisar su archivo robots.txt y asegúrese de que esté optimizado. De esta manera, Google y otros motores de búsqueda importantes "ven" todas las cosas fabulosas que ofrece al mundo con su sitio web.

![Únase a un dominio de Windows de Active Directory con Windows 7 o Vista [How-To]](/images/vista/join-an-active-directory-windows-domain-with-windows-7-or-vista-how-to.png)

Deja un comentario